WebTechExtractor #scraping desde #python

Conocer las tecnologías frontend de un portal web, muchas veces puede ser interesante para explicar performance o simple adopción tecnológica. En este caso las técnicas de #scraping nos pueden ayudar a concretar el objetivo. Hoy les comparto un simple modelo que permite detectar la presencia de webcomponents en entornos web.

Para simplificar agregue al script la posibilidad de consultar una lista de portales y el resultado del análisis se pueda subir a un folder de #Drive.[variante totalmente opcional]

Responderemos:

¿Este portal implementa #webcomponents?

El script recibe una archivo.txt que contiene una lista de portales a analizar, luego creamos un archivo *.csv con el resultado del análisis.

Formato de generación: [url portal],[webcomponents]

*Para webcomponents este prototipo propone un True/False, dependiendo si encuentra la presencia de estos componentes.

Veamos la rutina de identificación:

El script recibe una archivo.txt que contiene una lista de portales a analizar, luego creamos un archivo *.csv con el resultado del análisis.

Formato de generación: [url portal],[webcomponents]

*Para webcomponents este prototipo propone un True/False, dependiendo si encuentra la presencia de estos componentes.

Veamos la rutina de identificación:

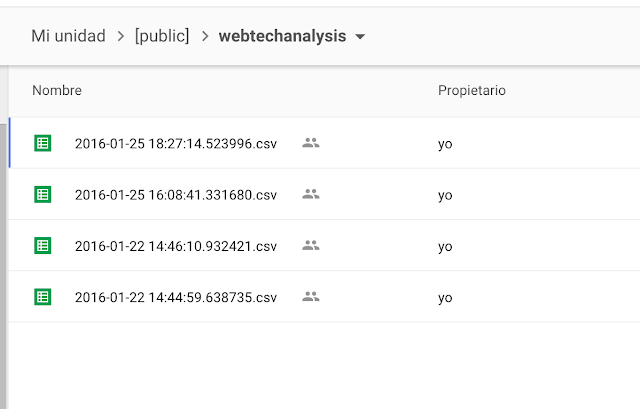

Ahora veamos el resultado, con la carga a drive directa:

El folder con las #snapshots:

Un ejemplo de análisis:

WebTechExtractor #scraping desde #python por Nicolas Bortolotti se distribuye bajo una Licencia Creative Commons Atribución-CompartirIgual 4.0 Internacional.

El folder con las #snapshots:

El proyecto en #github

Comentarios

Publicar un comentario